大家好,NVIDIA从云到边缘加速OpenAI gpt-oss模型部署,实现150万TPS推理相信很多的网友都不是很明白,包括NVIDIA,OpenAI也是一样,不过没有关系,接下来就来为大家分享关于NVIDIA从云到边缘加速OpenAI gpt-oss模型部署,实现150万TPS推理和NVIDIA,OpenAI的一些知识点,大家可以关注收藏,免得下次来找不到哦,下面我们开始吧!

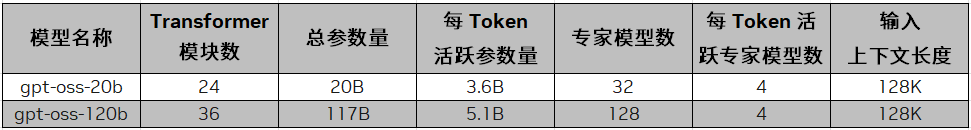

这两个GPT-oss模型是使用流行的混合专家模型(MOE)体系结构和Swigglu激活功能的文本推理大语模型(LLM),具有链条思维和工具调用功能。它的注意力层使用绳索技术,上下文大小为128K,交替使用完整的上下文和长度为128个令牌的滑动窗口。这两种模型均具有FP4精度,可以在单个80GB数据中心GPU上运行,并由Blackwell Architecture在本地支持。

这两种模型经过了NVIDIA HOPPER体系结构的张量核心GPU培训。 GPT-OSS-1220b型号需要超过210万小时的训练,而GPT-Oss-20b型号大约需要前者的十分之一。除了Nvidia tensorrt-llm外,NVIDIA还与几个顶级开源框架合作,例如拥抱面型变形金刚,Ollama,Vllm等,以提供优化的内核和模型增强功能。本文将介绍NVIDIA如何将GPT-oss整合到软件平台中,以满足开发人员的需求。

表1。OpenAIGPT-OSS-20B和GPT-OSS-1220B模型规格,包括总参数数量,活动参数数量,专家型号和输入上下文长度

NVIDIA还优化了OpenAI和社区的性能,并添加了以下功能:

tensorrt-llm gen内核,用于注意力填充,注意力解析和MoE低潜伏期。

布莱克韦尔(Blackwell)上的Cutlass Moe内核。

XQA内核在Hopper上提供专门的注意机制。

通过FlashInfer内核通过llm的FlashInfer内核库通过MOE路由内核提供了优化的关注。

支持MOE的OpenAi Triton内核,适用于Tensorrt-Llm和VLLM。

使用 vLLM 进行部署NVIDIA与VLLM合作,分析和提高了霍珀和Blackwell体系结构的性能,同时共同验证准确性。数据中心开发人员可以通过FlashInfer LLM内核服务库使用NVIDIA优化的内核。

VLLM建议将UV用于Python依赖性管理。用户可以使用VLLM启动与OpenAI API兼容的Web服务器。以下命令将自动下载模型并启动服务器。有关更多详细信息,请参见文档和VLLM食谱指南。

紫外线运行- vllm vllm服务OpenAi/gpt-oss-20b

使用 TensorRT-LLM 进行部署上述优化包含在NVIDIA/TENSORRT-LLM GITHUB库中,开发人员可以根据库中的部署指南启动其高性能服务器,并从指南后的拥抱面上下载模型检查点。 NVIDIA已与Transformers库合作,以增强新模型的开发人员体验。该指南还为Docker容器和性能配置提供了指南,以提供低潜伏期和最大吞吐量方案。

在 NVIDIA 系统上实现每秒 100 万个 Token 以上的性能NVIDIA工程师与OpenAI紧密合作,以确保新发布的GPT-OSS-1220B和GPT-OSS-20B型号实现NVIDIA BLACKWELL和NVIDIA HOPPER平台的第0天的性能提高。

根据早期性能测量,较大和更高的计算要求GPT-OSS-1220b模型可以实现每秒150万个令牌的性能或在NVIDIA系统上提供约50,000名并发用户。布莱克韦尔(Blackwell)配备了许多可以改善推理性能的建筑技术,包括使用FP4 Tensor Core的第二代变压器引擎,以及高带宽的第五代NVIDIA NVLINK和NVIDIA NVLINK转换,使72个Blackwell GPUS运行于GPU大型GPU。

NVIDIA平台的性能,灵活性和速度使生态系统能够在第0天以高通量和低单位令牌成本运行最新型号。

通过 NVIDIA Launchable 试用经过优化的模型Tensorrt-llm也可以在打开的AI食谱中使用Jupyterlab笔记本中的Python API部署,并用作构建平台中的NVIDIA。用户可以在预先配置的环境中单击一单击,并在多个云平台上进行测试。

使用 NVIDIA Dynamo 进行部署NVIDIA Dynamo是一个开源推理服务平台,可帮助开发人员为大规模应用程序部署OpenAI GPT-oss和其他模型。它与主流推理后端集成在一起,并提供诸如LLM感知路由,弹性自动缩放和独立服务之类的功能。当应用输入序列长度(ISL)时,Dynamo的分离服务可以显着提高性能。在32K ISL方案中,Dynamo的交互性能比具有相同系统吞吐量和GPU预算的合并服务要好4倍。要与Dynamo一起部署,请参阅本指南:

https://github.com/ai-dynamo/dynamo/blob/main/components/backends/trtllm/gpt-oss.md

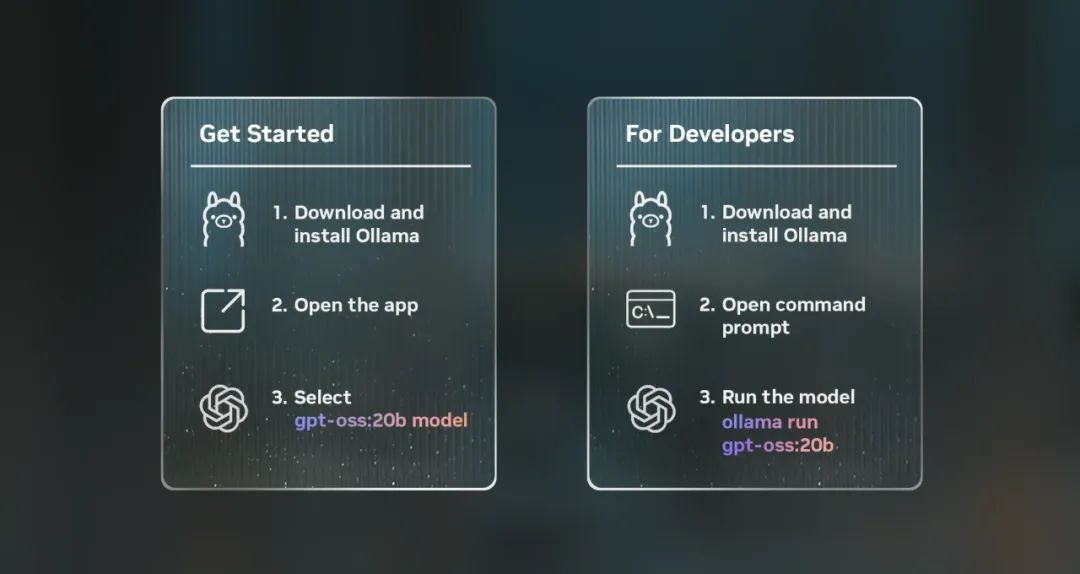

在 NVIDIA GeForce RTX AI PC 本地运行开发人员可以在本地运行AI,以进行更快的迭代,较低的延迟和更可靠的数据隐私保护。这两种型号均具有本机MXFP4精度,并且可以在NVIDIA RTX Pro GPU驱动的专业工作站上运行,其中GPT-SOSS-20B可以在任何GEFORCE RTX AI PC上部署,具有不少于16GB的视频存储器。开发人员可以通过Ollama,Llama.cpp或Microsoft AI Foundry Local使用其常用应用程序和SDK体验这两个模型。要使用,请访问RTX AI车库。

图1。使用Ollama安装和运行模型的步骤

通过 NVIDIA NIM 简化企业部署Enterprise Developers可以通过NVIDIA API目录中的NVIDIA NIM预览API和Web Playground环境尝试GPT-oss模型。这两个模型已被包装为NVIDIA NIM,可以在任何GPU加速基础架构上灵活而轻松地部署,同时确保数据隐私并提供企业级安全性。

下载和部署预包装,便携式和优化的NIM:

下载gpt-oss-1220b

链接:https://www.nvidia.cn/ai/

文档:https://docs.api.nvidia.com/nim/reference/openai-gpt-oss-120b

下载gpt-oss-20b

链接:https://www.nvidia.cn/ai/

文档:https://docs.api.nvidia.com/nim/reference/openai-gpt-oss-20b

好了,本文到此结束,如果可以帮助到大家,还望关注本站哦!

用户评论

该用户已上天

这太厉害了! 150万 TPS 推理速度 echt 超期待 NVIDIA 把 OpenAI 那些强大的大模型让更多人使用起来

有19位网友表示赞同!

余笙南吟

云到边缘一体化确实能解决很多现有的部署难题。之前对 OpenAI 的 GPT 模型一直印象深刻,现在更方便地应用了真是太爽了

有20位网友表示赞同!

信仰

这么高的推理速度,意味着什么? 可以想象未来各种实时对话、文本生成应用都会变得更加流畅!

有19位网友表示赞同!

久爱不厌

这个突破真的让我感觉人工智能的发展越来越快了,以前想用 OpenAI 的模型还得考虑资源和成本问题,现在看来就简单多了

有16位网友表示赞同!

拥菢过后只剰凄凉

150万 TPS 听起来很疯狂! 但对实际应用的提升效果还得再考察一下,毕竟技术与落地还有段距离

有13位网友表示赞同!

米兰

期待看到更多具体案例,看看这个突破能为哪些领域带来真正的改变。个人还是比较看好边缘计算在未来发展

有17位网友表示赞同!

孤岛晴空

我觉得这只是个开始。随着 OpenAI 模型和 NVIDIA 的技术不断进步,未来肯定会创造出更加惊人的成果!

有7位网友表示赞同!

寒山远黛

虽然推演速度快了,但我更关心模型的安全性问题。大型语言模型的安全使用需要引起足够的重视

有10位网友表示赞同!

各自安好ぃ

云到边缘部署是个好趋势,但会不会造成数据安全和隐私泄漏的风险? 需要更多保障机制才行

有16位网友表示赞同!

孤自凉丶

这个技术确实很牛逼,但对普通用户来说意义不大吧? 我现在还是更关注一些实实在在的生活应用

有16位网友表示赞同!

执念,爱

希望以后 OpenAI 的模型能够更加开源、易于使用。这样才能真正让大家都能体验到人工智能带来的便利

有19位网友表示赞同!

有你,很幸福

我比较担心这个技术垄断了谁的手里,导致 AI 技术不公平分布的问题。开源、共享才是未来发展的方向

有18位网友表示赞同!

闲肆

50万 TPS 已经很不错了,现在又提升到 150万 TPS,简直是飞速发展! 我相信不久的将来 AI 会影响我们生活的方方面面

有20位网友表示赞同!

话扎心

这个技术对游戏行业的影响应该很大吧? 未来游戏场景可能会变得更加丰富、智能化

有20位网友表示赞同!

未来未必来

对于一些开发者来说,这样的突破无疑是一个利好消息。更容易上手更强大的模型将会促进 AI 应用的创新

有14位网友表示赞同!

有阳光还感觉冷

不过,速度提升的同时不能忘记模型的可解释性和透明度的问题。毕竟 AI 技术最终还是需要为人类服务

有8位网友表示赞同!

孤败

希望 NVIDIA 不仅关注性能方面,也要加强对模型训练数据的质量控制,才能避免生成的内容偏差和错误

有19位网友表示赞同!

独角戏°

OpenAI 的 GPT 模型在写作、翻译等领域已经表现出色。现在通过 NVIDIA 的加速部署,可以预想未来会有更多的應用场景涌现出来

有17位网友表示赞同!

一生荒唐

150万 TPS 推理速度确实是强悍的表现,但更重要的是要将这强大的技术应用到实际问题中去解决.

有14位网友表示赞同!